众所周知,内容重复是搜索引擎优化中的一大忌,通常情况下转载的文章是很难获得高权重,所以站长们往往使用伪原创,下面是部分关于内容复制的信息图表,相信对各位会有所帮助。

#1 从博客上复制内容:

上图是主要针对博客这种网站媒体类型的,我们使用wordpress的时候经常将文章毫无保留地展示在首页,而不是使用输出摘要(就好像SEMWATCH那样),根据Randfish观察,其实这样子是会搜索引擎误认为内容重复。

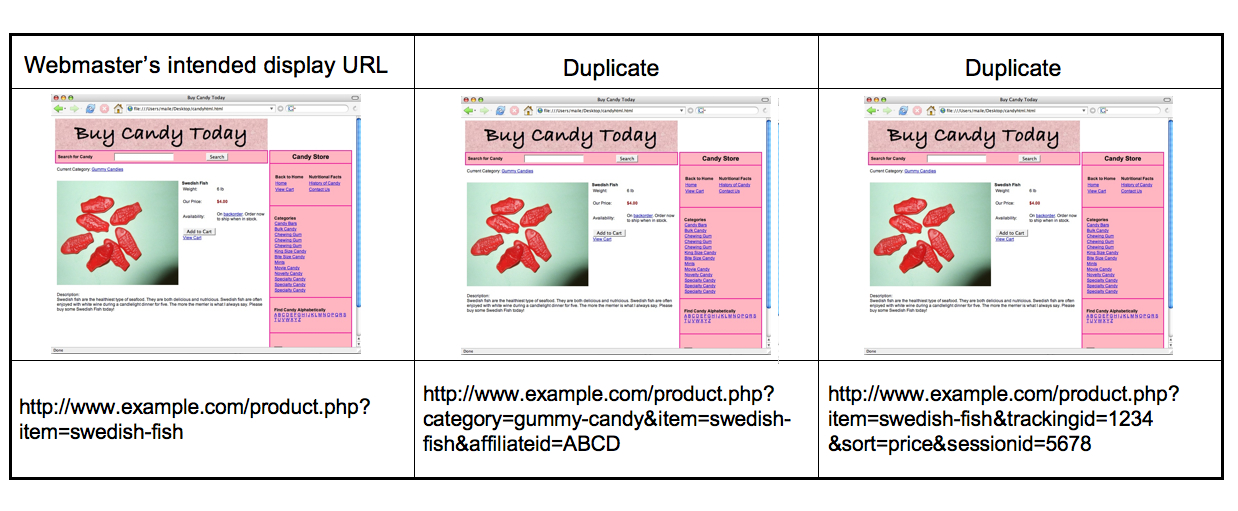

#2 URL参数引起的内容重复

究竟URL参数像Session IDs,Tracking IDs是怎样引起内容重复的呢?Googlewebmastercentral (需要翻墙) 透露,同一个产品页面,如果搜索引擎爬虫抓取可以通过多种链接途径抓取同一个产品页面,那样会有以下几种消极的影响:

1.多种URLs会稀释链接的广泛性。比如上图的产品页面,如果有50个导入链接,那有可能分别形成了3种导入URL途径,而不是唯一的某一个URL,这样就等于将导入链接传递的权重分散到3个不同的链接上。

2.搜索结果或许会呈现不友好的URL(比如一大串长长 的session ID,tracking ID)。从而在SERP中,降低了用户对该页面的清晰了解程度(英文url比如semwatch.org/sem,不仅仅具备搜索引擎友好性,更重要的是用户体验友好性),不利于品牌的塑造。

#3 搜索引擎对待内容重复的态度

从Search Engine Land给出上图可知,一般来说搜索引擎通过4个步骤来识别内容是原创还是复制:

1.发现。当搜索引擎爬虫发现新的内容,他会立刻与之前收录的内容进行比较确保内容的原创性。

2.丢弃。首先,搜索引擎会放弃收录那些来自链接工厂,MFA站点(Made For Adense)和被列入黑名单的IP的页面

3.解剖。下一步就是分析每个页面的 入站链接,判断链接的质量和源头。

4.决定。最后就是回顾之前收录的页面和相关链接,决定哪一个页面才是绝对原创。

广州市越秀区沿江中路313号康富来国际大厦1203-1205室

深圳市福田区深南大道6007号安徽大厦创展中心18楼14-17室

上海市长宁区延安西路895号申亚金融广场18楼D2-10

佛山市禅城区季华五路万科金融中心3313室

Copyright © 2003-

互诺科技, All Rights Reserved

粤公网安备 44010402000282号 粤ICP备09019378号-1

粤公网安备 44010402000282号 粤ICP备09019378号-1